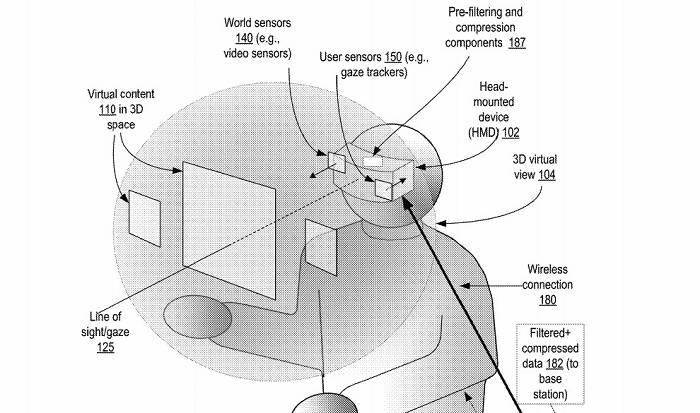

对于头戴式 VR / AR 设备来说,目前仍面临着性能方面的较大考验。无论是通过连接附加计算设备,还是通过板载芯片提供可独立使用的体验。至于增强现实系统,它还依赖于各项环境数据的收集(比如深度传感器),才能向用户交付预期中的混合现实图像,并且涉及对用户的视觉(眼球运动方向)进行实时追踪和分析运算。

资料图

经过多年改进,VR / AR 系统已能够达成相对高的分辨率和帧速率,但大量的数据分析,还是给设备造成了巨大的压力。

有趣的是,在周二公布的一项专利中,美国专利商标局(USPTO)揭示了苹果申请的一项名为“基于凝视方向的视频数据自适应预过滤”系统专利。

显然,苹果试图通过精简智能眼镜需要处理的数据范围,以减轻芯片的运算压力。

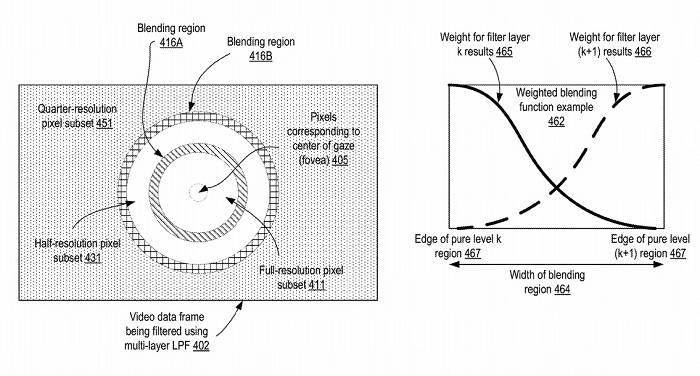

简而言之,该专利设想了将环境图像分割成不同的区域,然后根据典型的 AR / VR 数据点(比如头部位置和用户动作),对非重点目视区域实施相关的过滤。

过滤后的数据可通过有线或无线的方式传输到运算设备,然后反馈到头显上进行显示,如此循环往复。其背后的逻辑则是,用户不会始终关注环境中的完整信息。

当视线移动到另一个方向时,他们的眼睛更可能瞄向一侧,因此对非凝视区域的数据采集和运算是毫无意义的。

为了做到这点,系统需要对用户的目视进行追踪分析,然后将数据点套用到确切的图像数据帧,并优先处理重点的图像数据。而与第二帧相关的凝视检测,可减轻因眼睛焦点变化而造成的影响。

当然,这一理念并非苹果首创。其它厂商也提交过高精度渲染焦点区域图像,并适当降低周边区域图像分辨率的方法。至于苹果将于何时把这项技术运用到实际产品中,仍有待时间去检验。

合作机构

联系方式