前沿 | 微软AR/VR专利分享解决摄像头不同视角产生的遮挡或视差问题

11月03日)由于位置无法对应眼睛,对于基于摄像头透视的头显,用户可能很难正确地感知环境中对象相对于定义空间的空间关系。另外,同一定义空间内的多个用户相对于定义空间外的对象可能具有不同的视角。

所以在名为“Perspective-dependent display of surrounding environment”的专利申请中,微软提出了一种正确表示所定义空间的环境图像,尤其是在汽车这样的移动平台中时。简而言之,计算系统构建围绕所定义空间的环境的至少一部分的深度图和强度数据。然后将强度数据与深度图位置相关联。

另外,计算系统可以获得关于用户在所定义空间内的姿势信息,并基于所述用户的姿势确定所述用户正在注视的所定义空间周围环境的一部分。计算系统进一步从用户的角度获得表示环境部分的图像数据,

然后,计算系统根据用户视场范围内的深度图位置的强度数据生成用于显示的图像。通过这种方式,由一个或多个摄像头获得的环境视图可以重新投影到用户的视角,从而提供不会因摄像头的不同视角而产生遮挡或视差问题的环境正确视图。

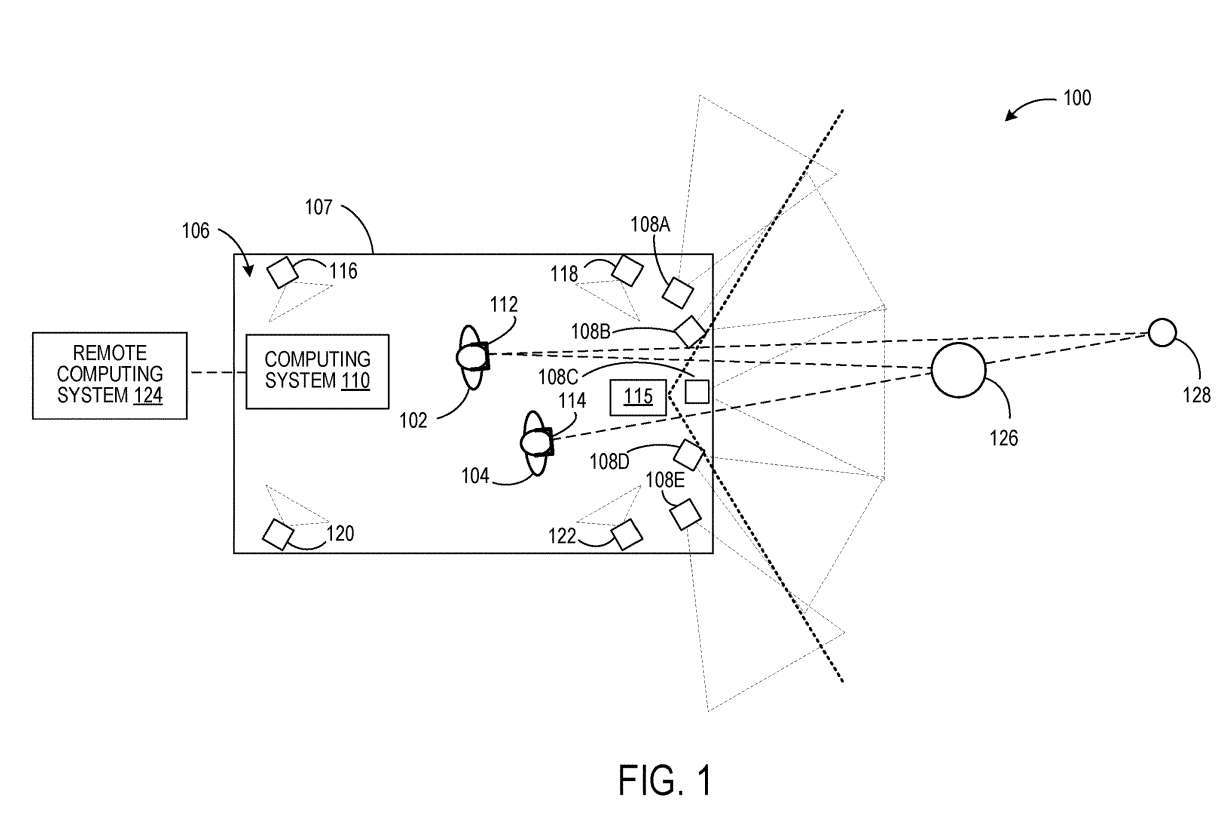

图1示出示例性使用场景100,其中用户102和104位于所定义的空间106内。用户102和104分别佩戴头显设备112和114。

计算系统110从每个用户102、104的角度生成表示围绕所定义空间的环境的图像数据。为此,计算系统110获得关于每个用户102和104在定义空间106中的姿势的信息。

在一个实施例中,每个用户102、104的姿态可以从固定在所定义空间的参考框架中的一个或多个成像设备确定,并且配置为在所定义空间内对用户进行成像。

在图1中,四个这样的成像设备描述为116、118、120和122。这种成像设备的实例可包括立体摄像头装置和深度传感器等。

可以将计算系统110配置为通过来自摄像头108A-108E的数据生成围绕定义空间106的环境的深度图。每个摄像头108A-108E配置为获取部分周围环境的强度图像数据。摄像头都知道彼此之间的空间关系。

另外如图1所示,相邻摄像头的视场重叠。因此,立体成像技术可用于确定周围环境中对象的距离,以生成深度图。在其它示例中,可使用与摄像头108A-108E分离的可选深度传感器115来获取周围环境的深度图。示例深度传感器包括激光雷达传感器和一个或多个深度摄像头。在这样的例子中,可选地获取强度图像的摄像头的视场可以不重叠。

来自摄像头的强度数据与深度图中的每个位置相关联,例如网格中的每个顶点或点云中的每个点。在其他示例中,对来自摄像头的强度数据进行计算组合,形成深度图中每个位置的计算组合强度数据。例如,当深度图位置由两个或多个不同摄像头的传感器像素成像时,可以计算组合来自两个或多个不同摄像头的像素值,然后存储深度图位置。

接下来,至少基于每个用户102、104的姿态,计算系统110可以确定围绕每个用户102、104所注视的定义空间的环境的一部分,从每个用户102、104的角度获得表示该部分环境的图像数据,并将图像数据提供给每个头显 112、114。

例如,通过知道用户在定义空间106内的姿态,以及周围环境的深度图与定义空间106的空间关系,可以将每个用户的姿态与深度图关联起来。然后,可以定义每个用户的视场并将其投影到深度图上,以确定在用户的视场内的深度图的一部分。

接下来,像光线投射这样的技术可以用来确定景深图中在视场内可见的位置。与所述位置相关联的强度数据可用于形成用于显示的图像。计算系统110可任选地与诸如云服务的远程计算系统124进行通信。在这样的实例中,可以通过远程计算系统124执行这样的处理步骤中的一个或多个。

通过这种方式,在一个确定的空间内,不同的用户可以从个人的角度来观察周围环境的图像。头显112从用户102的角度显示的图像可以包括对象126和对象128在环境中的视图,而对象128的视图可以由头显114从用户104的角度显示的图像中的对象126遮挡。

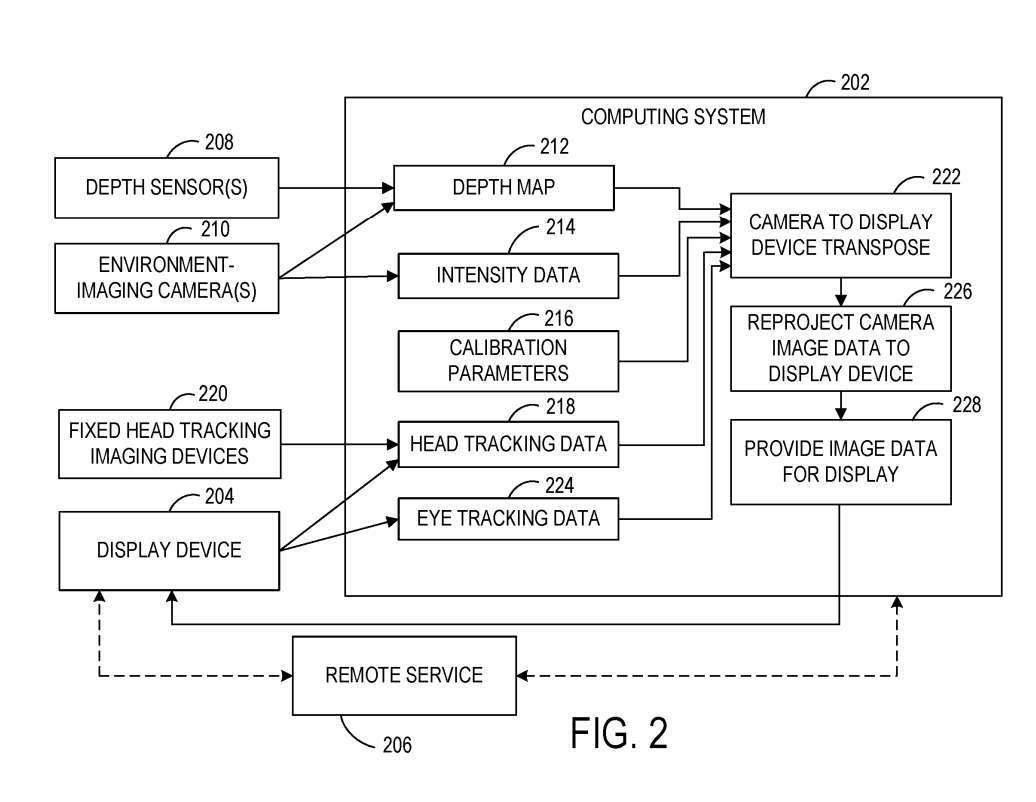

图2示出示例系统200的框图,其配置为从用户的角度向所定义空间内的用户显示围绕所定义空间的环境的图像。系统200包括位于所定义空间本地的计算系统202和位于所定义空间内的显示设备204。

系统200包括一个或多个摄像头210,并配置为对环境进行成像。在一个示例中,使用摄像头210作为被动立体摄像头并使用立体成像方法来获取强度数据和深度数据。在其他示例中,可选地使用一个或多个深度传感器208来获取所定义空间周围环境的深度数据。

计算系统202包括可执行指令,用于通过所述深度数据构造所述环境的深度图212。深度图212可以采取任何合适的形式,例如3D点云或网格。如上所述,计算系统202可以根据由一个或多个摄像头210获取的图像数据接收并存储与深度图212中的每个位置相关联的强度数据214。

深度传感器208和摄像头210的相对空间位置彼此校准,并校准到所定义空间的几何形状。因此,图2示出了可用作输入的校准参数216,以帮助将摄像头210和深度传感器208的视图转置为用户的姿势,从而帮助将图像数据从摄像头视角重新投影到用户视角以供显示。

在一个实施例中,由于显示设备204和/或定义的空间可以相对于周围环境不断移动,因此可以执行连续的外部校准以校准显示设备204到深度图212的位置。例如,显示设备204对深度图212的校准可以以显示设备204的显示的帧速率执行。

计算系统202可以进一步获得关于所述定义空间内用户的姿势的信息。用户的姿势可以更具体地指头部位置和头向,这有助于确定围绕用户正在寻找的定义空间的环境的一部分。计算系统202被配置为接收头部追踪数据218。头部追踪数据218可以另外或可选地从固定在所定义空间的参考框架中的一个或多个成像设备接收。

如上所述,计算系统202结合从头部追踪数据218确定的用户的姿势,使用深度图212和相应的强度数据214来确定从显示设备204的用户的角度进行显示的图像数据。

计算系统202可以根据用户的姿势确定用户正在看的环境的一部分,将用户的视场投影到深度图上,然后获得从用户的角度可见的深度图位置的强度数据。

提供给显示设备用于显示的图像数据可以在显示设备204的帧缓冲器内经历后期重投影。例如,后期重投影可用于在显示所呈现的图像之前直接更新所呈现的图像中对象的位置。

在这里,显示设备204位于移动的车辆中,显示设备204的帧缓冲区中的图像数据可以基于车辆在226处的图像形成与图像显示之间行驶的距离重新投影。计算系统202可以提供运动矢量以显示基于车辆运动的设备204,以用于后期重投影。在其它示例中,可以从来自显示设备204的本地惯性测量单元的数据确定运动矢量。

在一个实施例中,由摄像头210获取的强度数据的帧率可以不同于由深度传感器208获取的深度图的帧率。例如,用于获取深度图的帧率可以低于用于获取强度数据的帧率。

同样地,帧率可能根据车辆速度的变化、环境中移动的物体和/或其他环境因素而变化。在这样的示例中,在将强度数据与深度图位置关联之前,可以转译强度数据和/或深度数据,以校正在获得强度数据的时间和获得深度图的时间之间发生的运动。

在使用多个摄像头210获取强度数据的情况下,围绕所定义空间的环境中的物体可以出现在来自多个摄像头210的图像数据中。在这样的例子中,对对象成像的每个摄像头的强度数据可以重新投影到用户视角。

在其他示例中,来自对所述物体成像的一个摄像头或摄像头子集的强度数据可以重新投影到用户视角。这可能比将所有对对象成像的摄像头的图像数据转置到用户视角使用更少的计算资源。

在这样的示例中,可以使用来自具有确定为最接近用户视角的视角的摄像头的图像数据。在另一示例中,可对用于所选深度图位置的来自多个摄像头的像素强度数据进行平均或以其他方式计算组合,然后存储用于深度图位置。

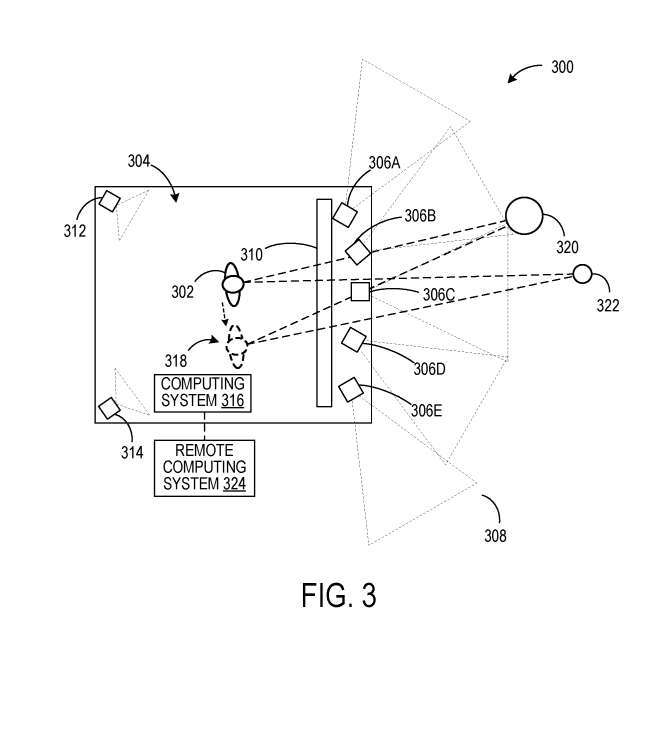

在图1的示例中,用户102和104通过头显112、114查看由计算系统110生成的依赖透视的图像。在图3的示例性场景300,用户正在位于限定空间304内的固定位置的显示面板查看由摄像头306A-306E获取的图像数据。

然而,不是从摄像头306A-306E的角度显示图像,而是将来自摄像头306A-306E的图像数据与从图像数据确定的深度图相关联,或者从深度传感器获取的数据确定的深度图相关联。

这允许将图像数据转换为用户302的透视视图。摄像头312、314对定义空间304的内部进行成像,以执行用户姿态追踪。一个或多个深度传感器附加地用于用户姿态确定。基于通过来自摄像头312、314的数据确定的用户姿态数据,可以在显示面板310显示来自用户302视角的图像数据。

在本例中,将图像数据重投影到用户302的视角,除了上述关于图2所述的操作之外,同时可以包括用户姿态以显示面板转置,因为用户302相对于显示面板的位置随着用户在定义空间304内移动而改变。

因此,当用户302移动到新的位置318时,环境中的对象320、322将从与用户302的原始位置不同的角度显示。计算系统316任选地可以与诸如云服务的远程计算系统324进行通信。

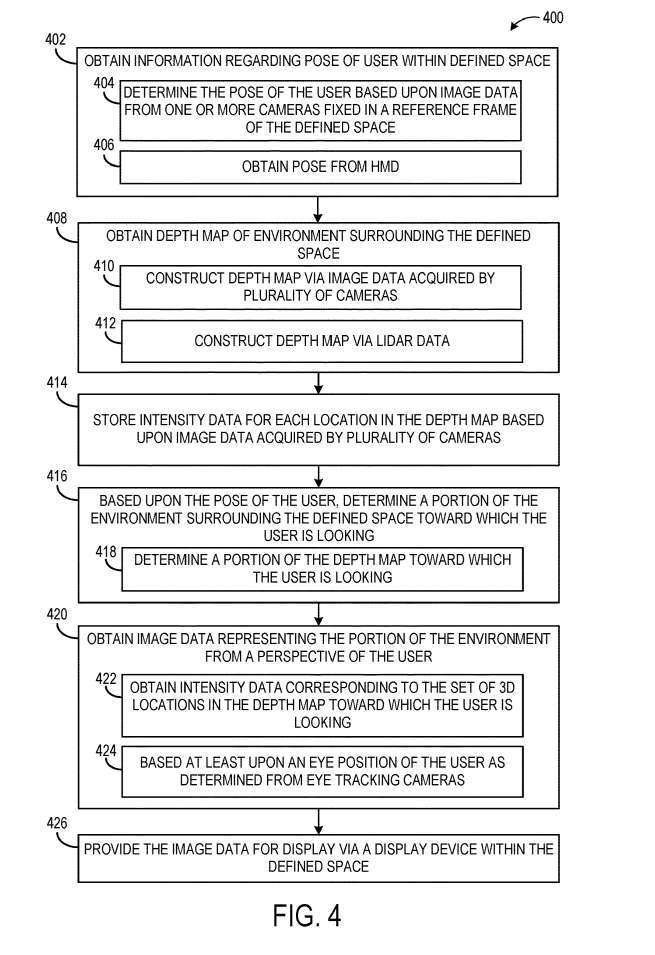

图4示出提供围绕所定义空间的环境的图像数据以从所定义空间内的用户的角度显示的示例方法400。

在402,方法400包括获取关于用户在定义空间内的姿势的信息。如上所述,例如,用户的姿势可以反映头部位置和头向。用户的姿势可以基于固定在空间的参考框架中的一个或多个摄像头的图像数据来确定。作为另一个示例,在406,用户的姿势可以从用户佩戴的头显接收,例如,根据来自头显的一个或多个图像传感器的图像数据确定。

在408,包括获取围绕所定义空间的环境的深度图。深度图可以通过在410处对环境进行成像的多个摄像头获取的图像数据来构建,或者可以通过在412处由激光雷达传感器获取的激光雷达数据来构建。

在其他示例中,可以利用其他合适类型的深度感测,例如飞行时间深度成像。然后在414,方法400包括存储深度图中每个位置的强度数据。

接下来在416,基于用户的姿势,确定围绕用户正在寻找的定义空间的环境的一部分。这可能包括在418确定用户正在看的深度图的一部分。在一个示例中,可以将用户的视场投影到深度图,以确定从用户的角度可以看到的深度图中的位置。

方法400同时包括,在420,从用户的视角获取表示所述环境部分的图像数据。方法400同时包括,在426,提供用于通过所定义空间内的显示设备显示的图像数据。

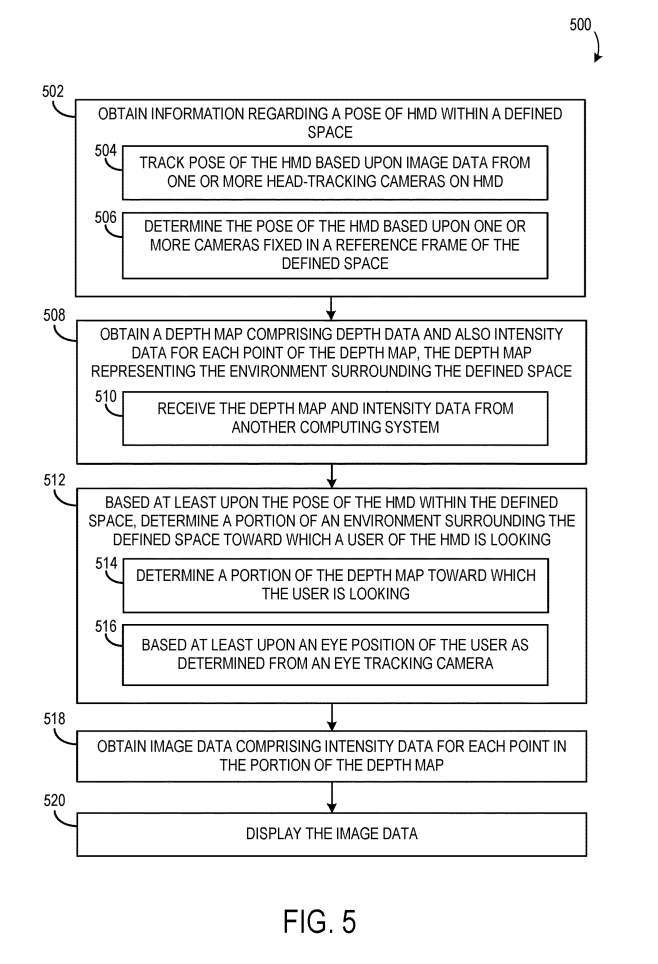

图5示出通过头显从用户的角度显示环境图像数据的示例方法500流程图。

在502,方法500包括获取关于在定义空间内的头显的姿态的信息。头显的姿态可以根据头显一个或多个头部追踪摄像头的图像数据进行追踪。在504,头显的姿态可以基于固定在定义空间的参考框架中的一个或多个摄像头来确定。在506,一个或多个固定摄像头与头显通信。

在508,方法500同时包括获取深度图,深度图包括深度数据和深度图的每个位置的强度数据,其中深度图表示围绕所定义空间的环境。

在512处,至少基于头显在所定义空间内的姿势,确定头显的用户正在注视的围绕所定义空间的环境的一部分。这可以包括在514,确定用户正在看的深度图的一部分。用户正在看的环境/深度图的部分可以进一步至少基于用户的眼睛位置。

方法500进一步包括,在518,获取包含深度图部分中每个位置的强度数据的图像数据,并且在520,显示图像数据。

相关专利:Microsoft Patent | Perspective-dependent display of surrounding environment

名为“Perspective-dependent display of surrounding environment”的微软专利申请最初在2022年3月提交,并在日前由美国专利商标局公布。